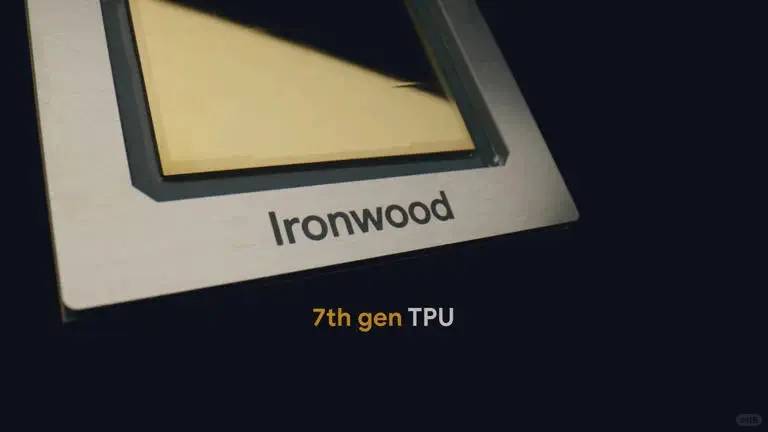

🔥 Auf der elektrisierenden Cloud Next Konferenz in Las Vegas machte Google durch die Vorstellung seines bahnbrechenden siebten Generation Tensor Processing Units (TPUs) – Ironwood – Schlagzeilen. Der Technologiegigant präsentierte atemberaubende Leistungsdaten: Jeder Ironwood-Pod liefert eine atemberaubende Rechenleistung von über 42 Exaflops, was das weltweit führende Supercomputer El Capitan um ein erstaunliches 24-faches übertreffen würde.

Google betonte, dass diese Architektur einen entscheidenden Wendepunkt in der AI-Rechnung darstellt, indem sich der Fokus von der "Training"-Phase auf ein "Inference-zuerst"-Paradigma verlagert.

💜 Anders als bei den vorherigen TPUs, die "Training + Inference" ausbalancierten, revolutioniert Ironwood nach der Deployment-Phase die Modelloperationen durch Spezialisierung auf Inferenzaufgaben. Jeder dieser leistungsstarken Pods enthält über 9.000 fortschrittliche Chips und erreicht doppelt so viel Energieeffizienz wie sein Vorgänger. Diese Innovation verbessert nicht nur die Leistung, sondern reduziert auch die Energiebedürfnisse für generative KI, was nachhaltige Skalierung möglich macht.

💛 Im Software-Bereich stärkte Google seine Gemini-Modellreihe mit dem bahnbrechenden Gemini 2.5 Flash. Dieser intelligente und kostengünstigere Lösungsfamilie fehlen die herkömmlichen Einschränkungen, die sofortige Antworten zu liefern. Diese innovative Serie bietet fortgeschrittene mehrstufige Schlussfolgerungs- und Reflexionsfähigkeiten, was unvorstellbares Potenzial für komplexe Anwendungen wie präzise Finanzprognosen oder revolutionäre pharmazeutische Forschung erschließt.

Comments are closed.